Texto em que o autor apresenta e defende suas ideias e opiniões, a partir da interpretação de fatos e dados.

Estamos preparados para a próxima virada das inteligências artificiais?

Em um primeiro momento, foi o Google que lançou uma das primeiras ferramentas massivas de inteligência artificial (IA) imagética generativa, a Deep Dream. Naquela época, a tecnologia pareceu empolgante, mais pelo potencial do que pela funcionalidade à época — com uma psicodelia aterrorizante de caras de cachorro aleatórias.

Mais recentemente, aplicativos de celular como o Zao passaram a automatizar deep fakes, em que as pessoas poderiam substituir o rosto de super-heróis e celebridades hollywoodianas com suas próprias faces. Ainda, Wombo.ai viralizou nas redes sociais ao conseguir transformar qualquer retrato em um vídeo cantante.

Mais recentemente, a mesma empresa lançou Dream.ai, uma IA baseada em inserções de texto. Basta escrever uma frase ou palavra e a rede neural irá gerar uma imagem ao estilo pictórico escolhido (psicodélico, fantasia, realista, expressionista etc).

Essa também é a mecânica da plataforma Pollinations.AI, criada pelo cientista de dados Thomas Haferlach. Depois de estudar ciência de dados e inteligência artificial na Universidade de Edimburgo, Thomas morou nove anos em São Paulo, onde criou um coletivo artístico com o qual concebeu e implementou diferentes instalações interativas na cidade, que combinavam sua paixão por arte, pesquisa e tecnologia. Pollinations.A é uma das suas mais recentes empreitadas.

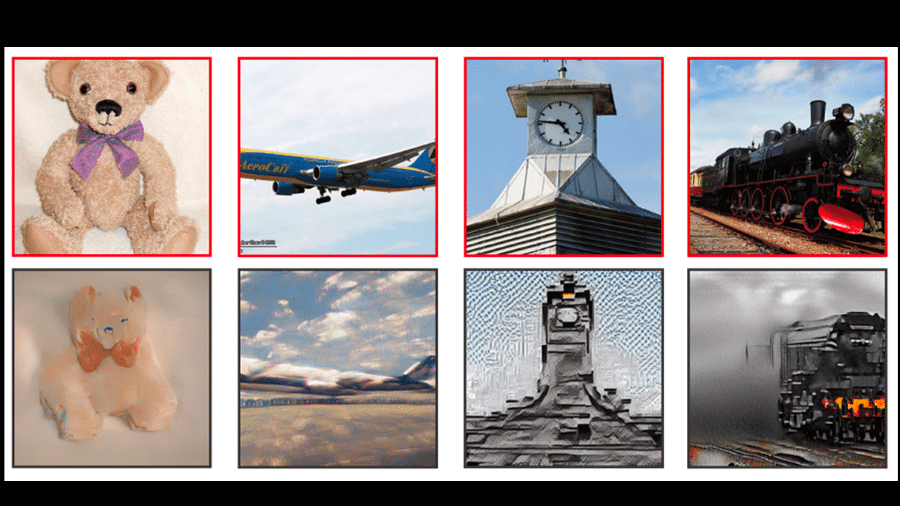

Perguntei a Thomas como a tecnologia funciona. Ele me explicou que esses programas usam modelos de "deep learning", que é um tipo de aprendizagem de máquina que treina computadores para realizar tarefas. Com o avanço dessa tecnologia, também os modelos generativos de imagem se popularizaram, mas suas aplicações ainda eram muito limitadas.

Na opinião de Thomas, "a mágica começa a acontecer quando usamos esses modelos generativos combinados a modelos de outras modalidades, por exemplo, modelos que podem entender como textos e imagens se relacionam entre si".

Essa foi a premissa do modelo CLIP, lançado dez meses atrás pela OpenAI, que tem a capacidade de julgar quanto um texto corresponde a uma determinada imagem. "Esse modelo aprendeu de uma grande base de dados com milhões de imagens associadas a descrições textuais", explica o desenvolvedor.

Muito rapidamente, uma comunidade de hackers, pesquisadores e artistas conseguiu conectar o modelo CLIP a outros modelos que podem gerar imagens. Para a surpresa de todos, a combinação desses modelos tornou possível que um usuário humano escrevesse uma frase curta e o modelo de aprendizagem de máquina conseguisse desenhar uma interpretação criativa dessas palavras.

Thomas explica isso a partir de uma analogia em que um suposto rei tem o desejo de fazer uma obra de arte específica, só que ele não tem habilidade e nem tempo para isso. Para realizar seu desejo, esse rei tem acesso a um pintor surdo que é ótimo em desenhar qualquer tipo de imagem, mas não consegue entender textos; e um crítico de arte que já viu e leu sobre muitas obras de arte e imagens, mas não tem nenhum talento para a pintura. Apesar disso, o crítico consegue se comunicar com o pintor para confirmar se sua obra está de acordo com o pedido do rei ou não.

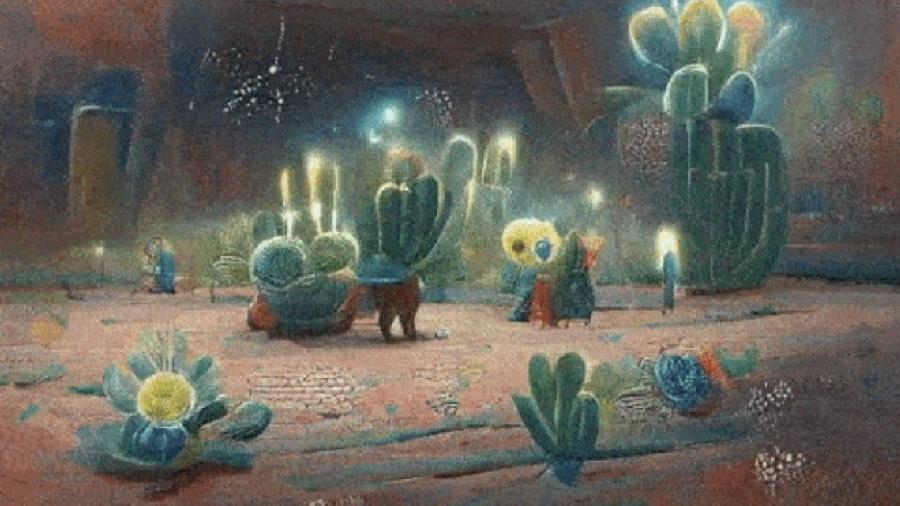

"Num primeiro momento, o rei irá dizer ao crítico de arte qual é a obra que ele quer, por exemplo: 'Faça uma pintura de cactos e flores de peyote brilhantes numa noite dos sonhos no deserto do Arizona. Pintado por Shaun Tan, Ivan Bilibin e Studio Ghibli", explica Thomas. "Esse é o comando para que o pintor comece a fazer uma imagem aleatória. Nesse ínterim, o crítico de arte observa a imagem e confirma ao pintor se ele está no caminho certo ou não de obedecer ao pedido do rei."

Juntos, os dois personagens alegóricos trabalham modificando a imagem e repetindo esse processo em diferentes etapas, até que o desenho comece a se parecer mais com o que o rei pediu de verdade. "Assim que o crítico de arte estiver satisfeito com a obra, o rei pode apreciar sua pintura única."

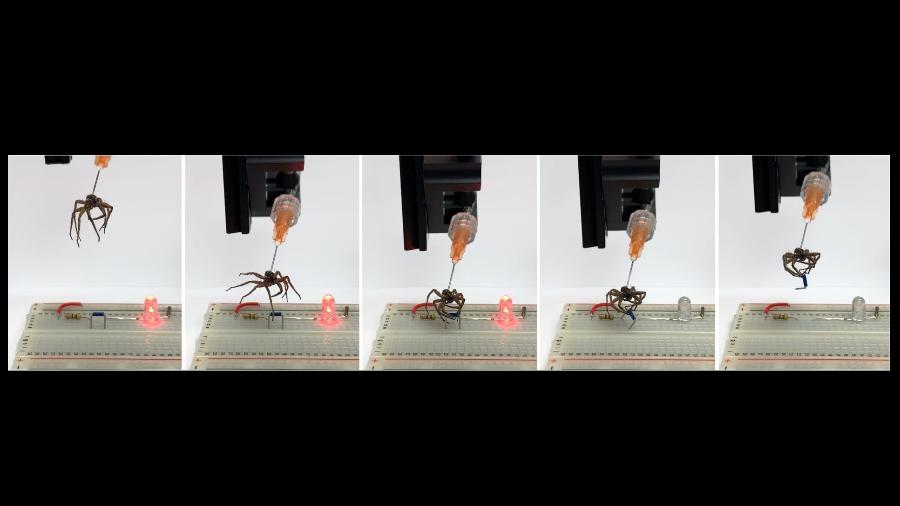

É durante o tempo de processamento que a IA generativa consegue ir moldando a imagem — em alguns casos, como em Pollinations.AI, é possível ver o processo acontecendo ao vivo. A maneira como o programa funciona é através de duas fases: treinamento e inferência. "Para treinamento, os pesquisadores reúnem grandes bases de imagens, texto ou outras mídias da internet e que são repetidamente inseridas em uma grande rede neural, que é uma abstração matemática simplificada de como o cérebro biológico funciona", explica Thomas.

Nessa primeira fase de treinamento, a rede neural aprende como representar todos esses dados internamente, o que significa que o programa não precisa acessar a internet ou a base de dados original para poder recriar o conteúdo. "Já que o programa não consegue simplesmente memorizar todas as imagens, o processo força a rede a comprimir essa informação e achar formas mais abstratas de armazenamento", continua o desenvolvedor. "Assim que um modelo é treinado, ele pode ser baixado e usado para gerar novos conteúdos ou combiná-lo a outros modelos, como nesse caso do formato texto para imagem."

Mas por que o modelo só pode acessar esses dados abstratos e não continuar diretamente conectado a uma base? Thomas menciona um artigo publicado no blog da Universidade Stanford (EUA), no qual os pesquisadores discutem as vantagens de se permitir que esses modelos acessem dados externos. No entanto, essa é uma hipótese ainda muito recente e não se tem certeza quanto à sua comprovação.

Enquanto isso, artistas poderiam usar as criações abstratas de plataformas como Dream.aiou Pollinations.AI em seu próprio processo criativo. Para Thomas, apesar de ainda ser um nicho, já tem bastante gente fazendo esse tipo de experimento. "Na minha opinião, é só uma questão de tempo até se tornar algo popular. Até o dentista de um colega começou a usar o Pollinations.AI para gerar arte."

Até 18 de dezembro, a Galeria König em Berlim estava com a exposição "MACHINE HALLUCINATIONS: NATURE DREAMS", criada pelo designer e artista turco-americano Refik Anadol. Entre telas pequenas e um grande salão preenchido com um gigantesco monitor LCD, a obra de Anadol é resultado de sua pesquisa sobre as intersecções entre a consciência humana, os arquivos da natureza e a inteligência das máquinas.

Conforme a galeria descreve em seu site, o trabalho inclui "uma gigantesca escultura de dados projetando pigmentos da natureza dinâmicos e gerados por máquina", bem como uma projeção feita na torre St. Agnes, na qual a visualização é criada a partir dos dados ambientais coletados em tempo real. Para criar essas imagens generativas, Anadol e seu time coletaram dados de arquivos digitais e públicos, processando milhões de memórias fotográficas em um modelo de classificação de aprendizagem de máquina. Depois, essas imagens foram organizadas em grupos temáticos para melhor entender a semântica desses dados, expandindo-os.

Assim como proposto pelo enxadrista Garry Kasparov, ao ser vencido pela IA Deep Blue criada pela IBM, um humano ou uma máquina sozinhos não são tão potentes quanto a união das partes. À medida que vemos esses avanços, a pergunta que fica é se não chegaremos mesmo a um ponto em que a IA superará nossas capacidades humanas — o que Ray Kurzweil chama de Singularidade, ou então o que também pode ser referido como a conquista de uma Inteligência Artificial Generalista ("general artificial intelligence" ou AGI).

Thomas acha que seu posicionamento talvez seja um pouco mais radical, mas sua posição é baseada em todos esses avanços que estão acontecendo no setor de modelagem linguística e aprendizagem multimodal, isto é, aprender a conectar diferentes formatos de dados (vídeo, áudio, texto etc). "Para mim, nós estamos em um claro e inescapável trajeto que nos levará à AGI", diz ele, dando o exemplo da IA de modelagem linguística GPT-3 — a mesma usada por Allado-McDowell em seu livro "Pharmako-AI".

O desenvolvedor explica que o modelo é bastante simples: basta inserir algumas palavras e a IA irá prever qual será o conteúdo da próxima frase. "Ao fazer isso repetidamente, o GPT-3 aprende a escrever e continua escrevendo muito bem", explica Thomas. "Para isso, é preciso que a IA desenvolva uma forma de autoconsciência ou consciência mesmo, só para poder realizar o que foi programado, no caso, prever a palavra seguinte em um texto."

Falar sobre consciência de máquina, portanto, não é algo assim mais tão absurdo ou coisa de ficção científica. Na verdade, estudiosos como o neurocientista e filósofo David Chalmers já estão falando sobre esse tipo de assunto, em específico sobre o modelo GPT-3:

"O que me fascina sobre o GPT-3 é que ele sugere um caminho estúpido à inteligência artificial generalizada (ou AGI). O treinamento do GPT-3 é estúpido. É só sobre analisar as estatísticas da linguagem. Mas para fazer isso bem feito, algumas capacidades de uma inteligência generalista são necessárias, e o GPT-3 está alcançando vislumbres disso. Há muitas limitações, falhas e erros, mas o ponto não é tanto o GPT-3 em si, mas sim para onde ele está indo. Levando em consideração o progresso do GPT-2 para o GPT-3, quem garante o que o GPT-4 e outras gerações nos trarão?"

Nos estudos do futuro, o conceito da "Lei de Amara" é usado para dizer que, no curto prazo, tendemos a achar que uma tecnologia irá proporcionar muito mais do que ela é capaz. No longo prazo, temos mais dificuldade em imaginar uma virada de chave. Essa é a grande charada das tecnologias exponenciais: elas têm como característica um desenvolvimento em nível exponencial, não linear, que é como o nosso cérebro funciona. Com isso em mente, a opinião de Thomas passa a fazer mais sentido, o que pode ser algo que nos causa ansiedade, seja por medo ou por antecipação.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.